Найден способ удалять изображения из памяти моделей.

Учёные из Техасского университета в Остине Для просмотра ссылки Войдиили Зарегистрируйся метод «машинного отучения» для изображений, используемых в искусственном интеллекте. Открытие позволяет эффективно удалять насильственные изображения и авторские материалы без необходимости переобучения модели.

Исследователи подчеркивают, что ранее единственным способом удалить проблемный контент являлось создание модели заново с нуля. Новый метод позволяет избежать этого, сохраняя остальные данные в модели.

Искусственный интеллект, в особенности генеративные модели, обучаются на данных из интернета, что включает в себя авторские материалы, личную информацию и нежелательный контент. Недавний Для просмотра ссылки Войдиили Зарегистрируйся против OpenAI, разработчика ChatGPT, за использование их статей в обучающих данных подчеркивает актуальность проблемы.

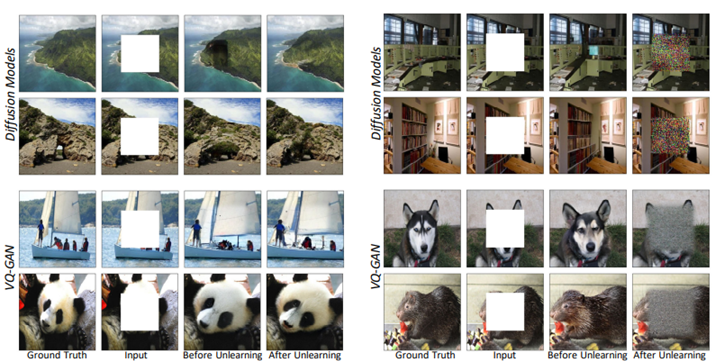

Исследование сосредоточено на моделях преобразования изображений, которые могут, например, превращать вводное изображение в эскиз или изменять сцену в соответствии с указаниями. Новый алгоритм позволяет модели «забывать» или удалять контент по запросу, избегая повторного обучения с нуля. Модерация и удаление контента осуществляются людьми, что добавляет дополнительный уровень проверки и возможность реагировать на отзывы пользователей.

Процесс «забывания» изображений путем изменения деталей (слева) или добавления шума (справа)

«Машинное отучение» (Machine unlearning) — это развивающееся направление, ранее применявшееся главным образом к классификационным моделям, определяющим категории данных, например, отличающим собак от кошек. Применение такого подхода к генеративным моделям, особенно для изображений, является относительно новым и малоизученным.

Учёные из Техасского университета в Остине Для просмотра ссылки Войди

Исследователи подчеркивают, что ранее единственным способом удалить проблемный контент являлось создание модели заново с нуля. Новый метод позволяет избежать этого, сохраняя остальные данные в модели.

Искусственный интеллект, в особенности генеративные модели, обучаются на данных из интернета, что включает в себя авторские материалы, личную информацию и нежелательный контент. Недавний Для просмотра ссылки Войди

Исследование сосредоточено на моделях преобразования изображений, которые могут, например, превращать вводное изображение в эскиз или изменять сцену в соответствии с указаниями. Новый алгоритм позволяет модели «забывать» или удалять контент по запросу, избегая повторного обучения с нуля. Модерация и удаление контента осуществляются людьми, что добавляет дополнительный уровень проверки и возможность реагировать на отзывы пользователей.

Процесс «забывания» изображений путем изменения деталей (слева) или добавления шума (справа)

«Машинное отучение» (Machine unlearning) — это развивающееся направление, ранее применявшееся главным образом к классификационным моделям, определяющим категории данных, например, отличающим собак от кошек. Применение такого подхода к генеративным моделям, особенно для изображений, является относительно новым и малоизученным.

- Источник новости

- www.securitylab.ru